ChatGPT 4o ora consente di generare immagini di personaggi famosi in contesti realistici, ma mai avvenuti. Un passo avanti che solleva rischi concreti di disinformazione visiva. Ecco cosa sta cambiando, come riconoscerlo e perché serve essere responsabili.

Restando sul tema di intelligenza artificiale, vi sarete accorti anche voi che ultimamente si è potenziata la possibilità di generare immagini. E di generare queste immagini anche con personaggi noti, personaggi pubblici, personaggi famosi, politici… e addirittura ritrarli in situazioni che prima non era possibile fare.

Mi riferisco in particolare all’aggiornamento di ChatGPT, che ha potenziato il modello 4o al punto da far generare, da riuscire, da permettere agli utenti di generare immagini che prima non era possibile fare.

Ci concentriamo sempre sulle capacità dell’intelligenza artificiale, di questi modelli che sono sempre più aggiornati, sempre più potenti, ma non ci soffermiamo mai sul fatto che prima non era possibile fare una cosa, e invece oggi è possibile farlo.

Quali immagini può generare oggi ChatGPT 4o

Come appunto questa, che in realtà definisce ancora di più la vicinanza tra ciò che era lecito fare e ciò che in realtà è un rischio, un potenziale rischio di disinformazione che è alla portata di tutti.

Perché questo?

Perché in realtà le immagini sono, l’abbiamo visto anche in questi giorni, il contenuto più facilmente condivisibile, più facilmente condiviso sulle piattaforme, e che facilmente può diventare anche virale.

Lo diventa nel momento in cui noi abbiamo la possibilità di ritrarre personaggi noti, famosi. Faccio l’esempio di Trump che è sulla spiaggia di Copacabana con Elon Musk a bere un drink. Una situazione che prima su ChatGPT non era possibile fare e che adesso invece è alla portata di tutti.

Sono quelle situazioni in cui abbiamo questa sorta di voglia di vedere personaggi famosi in situazioni che molto probabilmente non vivrebbero mai, e che difficilmente sarebbero ritratte in quella situazione.

Questo significa che, in realtà, anche noi potremmo essere al centro di quel contenuto. E quindi, avendo la possibilità di poter ritrarre e permettendo anche agli utenti la possibilità di generare immagini come queste, nulla vieta che un giorno ci possa essere un Franz Russo, tanto per fare un esempio, che si trova in un determinato luogo, con una determinata situazione, ma in realtà tutta quell’immagine non esiste.

Il confine tra immagini reali e false è sempre più sottile

Quindi il confine tra ciò che è possibile, che è realistico, e ciò che è in realtà una potenziale disinformazione, si sta avvicinando sempre di più.

Ma perché ChatGPT arriva a trasferire questo senso di responsabilità un po’ più verso gli utenti?

La questione è molto semplice, ed è di natura commerciale.

Il caso Grok 3 di xAI

Sul mercato dell’intelligenza artificiale esiste già Grok 3, la terza versione di questa intelligenza artificiale realizzata da xAI, che è una delle società di Elon Musk.

Grok si trova all’interno della piattaforma X, e permette fin dall’inizio, da quando è stata generata la prima versione, di generare immagini che ritraggono personaggi famosi anche con un limite sempre più alto, con un’asticella sempre più alta, con possibilità di ritrarre personaggi famosi sempre più alla portata di chiunque.

L’immagine di Papa Francesco col piumino bianco

Ricordate quando nel 2023 si realizzarono quelle immagini con Papa Francesco, il famoso piumino? Ebbene, quell’immagine lì oggi ChatGPT la fa tranquillamente.

L’immagine del falso arresto di Trump

Oppure un’altra famosa immagine di Donald Trump circondato da poliziotti che cerca di fuggire a un possibile arresto: ebbene, quell’immagine ChatGPT oggi la realizza tranquillamente, senza nessun problema.

Questo significa che il confine, ripeto, di quello che noi possiamo generare rispetto a una potenziale disinformazione, si sta sempre di più assottigliando, sempre di più avvicinando. Non si riconosce più il rischio di quello che riusciamo a generare.

Ci sono addirittura delle immagini, tipo Bill Gates con una birra in mano, realizzata da me su ChatGPT, che alcuni strumenti di verifica, come Illuminarty, addirittura fanno fatica a definire se sia un’immagine realistica, umana, oppure se sia generata da intelligenza artificiale.

Questo già ci dice molto di come effettivamente anche questi strumenti di verifica possono essere utili o addirittura affidabili.

Piccoli suggerimenti per riconoscere immagini IA

Per cercare poi di offrire qualche suggerimento su come accorgerci del fatto che queste situazioni, alcune immagini, possono sembrare artefatte, ecco alcuni dettagli:

-

lo sfondo, magari un po’ confuso;

-

scritte non precise;

-

mani, che erano un grande problema per DALL·E 3;

-

oppure la pelle, che è sempre perfetta, molto liscia, e quindi già di per sé ti porta a pensare che sia un’immagine artefatta, anche se in alcuni casi anche questo dettaglio è in netto miglioramento,

-

o addirittura l’esposizione della luce, che in alcuni contesti è quasi irrealistica: quel tipo di luce difficilmente può essere naturale.

Oppure ancora, cercare di avvalersi sempre della ricerca inversa, quindi utilizzare motori di ricerca – ad esempio Google Immagini – sottoponendo i contenuti per avere una risposta dal motore di ricerca sul fatto che quell’immagine sia stata già utilizzata in altri contesti o meno.

Anche perché è capitato, anche di recente, che alcune immagini realizzate con intelligenza artificiale—quindi neanche con modelli di ricerca tanto evoluti, perché l’evoluzione l’abbiamo avuta molto molto di recente—siano stati confusi come contenuti realistici.

Quindi il senso di responsabilità, da parte nostra, ormai è imprescindibile. Non possiamo che fare affidamento a quel senso di responsabilità, alla consapevolezza del fatto che stiamo utilizzando strumenti che in alcuni contesti possono generare contenuti potenzialmente di disinformazione.

Guarda il video

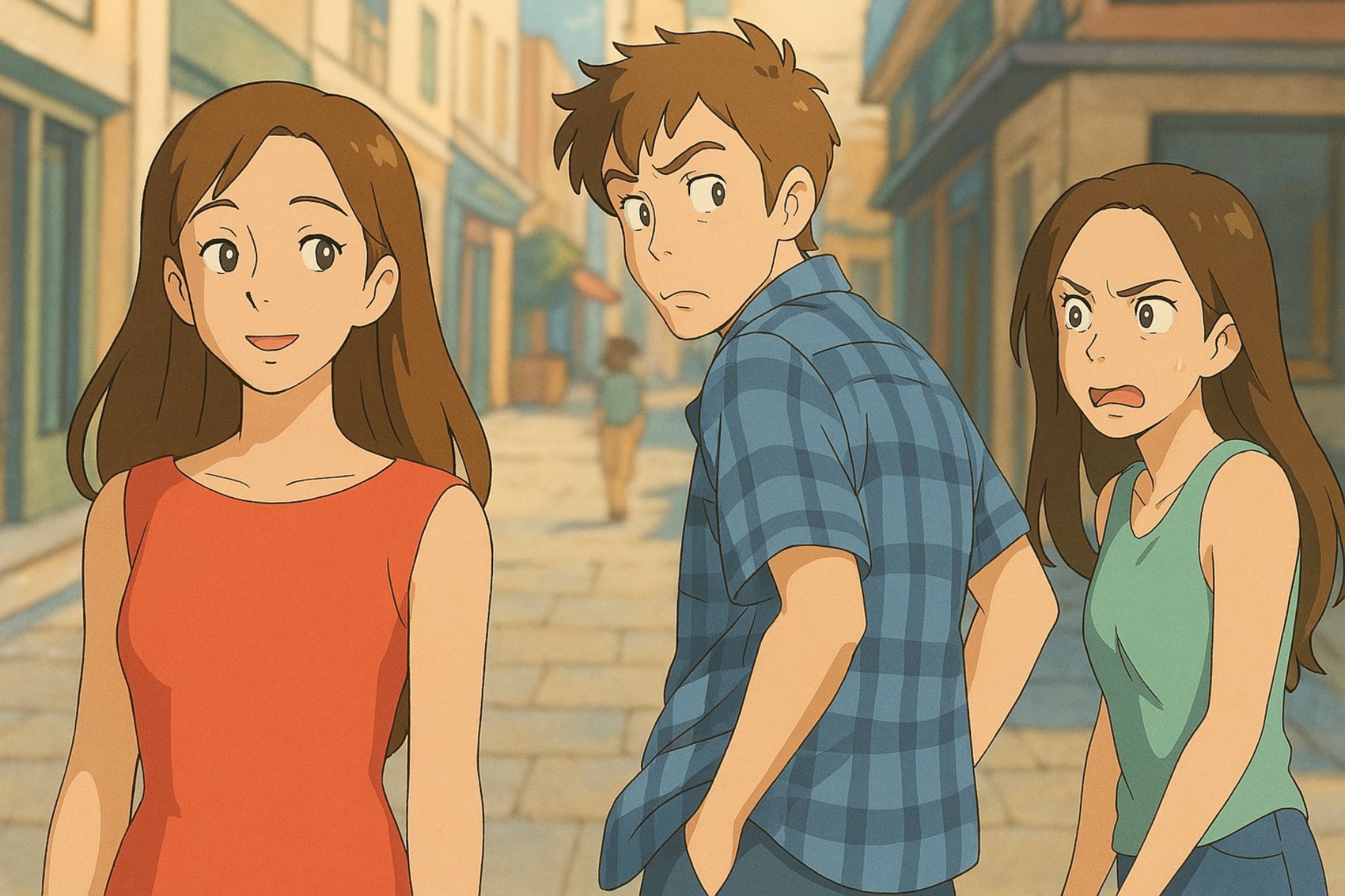

Anche la ghilbizzazione aiutare a confondere

Anche lo stesso fenomeno della ghiblizzazione, di cui abbiamo parlato anche in un altro video, è uno di quegli elementi che ci porta a trasformare quella che è la realtà in un contesto diverso: più armonioso, più pastellato, più colorato, più dolce.

Ma anche quello diventa una situazione per mascherare altre situazioni irrealistiche. Condividerle in un contesto completamente diverso, anche quello è un potenziale rischio di disinformazione.

Quindi, rispetto anche alla potenzialità, al modo in cui noi possiamo effettivamente affrontare questo, è sicuramente importante conoscere meglio i modelli. E quindi avvalerci di quella competenza, AI Literacy, conoscenza approfondita dei modelli. Dobbiamo prestare attenzione su come utilizziamo questi modelli e per cosa li vogliamo usare.

Che sia per uso personale, per lavoro, per tutte le attività che facciamo, dobbiamo prestare sempre molta attenzione e affidarci a un senso di responsabilità. Chiederci sempre:

qual è la motivazione che mi porta a usare questo modello?

Cosa voglio davvero fare?

E imparare, anche noi utenti, a riconoscere sempre meglio queste immagini, a sapere che tipo di immagine abbiamo davanti, a saperle riconoscere ed evitare che diventiamo anche noi potenziali diffusori di disinformazione.